NetworkTables API

Limelight OSにはNetworkTables 4クライアントが搭載されています。設定UIで構成されたチーム番号/IDに基づいて、FRCロボット上で動作するNetworkTables 4サーバーに自動接続します。

すべてのデータはデバイス名と一致するテーブルに公開されます(例:"limelight")。カメラにホスト名/ニックネームが割り当てられている場合、テーブル名は完全なlimelight名と一致します(例:"limelight-top")。

LimelightLib WPIJavaとLimelightLib WPICPPは、NetworkTablesを介してLimelightデバイスと通信します。

基本ターゲティングデータ

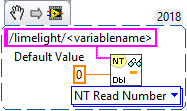

以下のコードを使用します:

- Java

- LabView

- C++

- Python

NetworkTableInstance.getDefault().getTable("limelight").getEntry("<variablename>").getDouble(0);

nt::NetworkTableInstance::GetDefault().GetTable("limelight")->GetNumber("<variablename>",0.0);

NetworkTables.getTable("limelight").getNumber('<variablename>');

このデータを取得します:

| キー | 型 | 説明 |

|---|---|---|

| tv | int | 有効なターゲットが存在する場合は1。有効なターゲットが存在しない場合は0 |

| tx | double | クロスヘアからターゲットへの水平オフセット(LL1: -27度〜27度 / LL2: -29.8〜29.8度) |

| ty | double | クロスヘアからターゲットへの垂直オフセット(LL1: -20.5度〜20.5度 / LL2: -24.85〜24.85度) |

| txnc | double | 主点ピクセルからターゲットへの水平オフセット(度) |

| tync | double | 主点ピクセルからターゲットへの垂直オフセット(度) |

| ta | double | ターゲット面積(画像の0%〜100%) |

| tl | double | パイプラインのレイテンシ寄与�(ms)。合計レイテンシを得るには"cl"に加算します。 |

| cl | double | キャプチャパイプラインレイテンシ(ms)。センサーの中央行の露光終了からトラッキングパイプライン開始までの時間。 |

| t2d | double | タイムスタンプ一致統計の複数の値を含む配列:[targetValid, targetCount, targetLatency, captureLatency, tx, ty, txnc, tync, ta, tid, targetClassIndexDetector, targetClassIndexClassifier, targetLongSidePixels, targetShortSidePixels, targetHorizontalExtentPixels, targetVerticalExtentPixels, targetSkewDegrees] |

| getpipe | int | カメラの現在アクティブなパイプラインインデックス(0 .. 9) |

| getpipetype | string | パイプラインタイプ 例:"pipe_color" |

| json | string | ターゲティング結果の完全なJSONダンプ。'output'タブでパイプラインごとに有効にする必要があります |

| tclass | string | プライマリニューラル検出器結果またはニューラル分類器結果のクラス名 |

| tc | doubleArray | クロスヘア領域(3x3ピクセル領域)下の平均HSV色をNumberArrayとして取得 |

| hb | double | ハートビート値。フレームごとに1増加し、20億でリセット |

| hw | doubleArray | HWメトリクス [fps, CPU温度, RAM使用量, 温度] |

| crosshairs | doubleArray | 2Dクロスヘア [cx0, cy0, cx1, cy1] |

| tcclass | string | 分類器パイプラインの計算されたクラス名 |

| tdclass | string | 検出器パイプラインのプライマリ検出名 |

AprilTagと3Dデータ

以下のコードを使用します:

- Java

- C++

NetworkTableInstance.getDefault().getTable("limelight").getEntry("<variablename>").getDoubleArray(new double[6]);

nt::NetworkTableInstance::GetDefault().GetTable("limelight")->GetNumberArray("<variablename>",std::vector<double>(6));

このデータを取得します:

| キー | 型 | 説明 |

|---|---|---|

| botpose | doubleArray | フィールド空間でのロボット変換。移動(X,Y,Z)はメートル、回転(Roll,Pitch,Yaw)は度、合計レイテンシ(cl+tl)、タグ数、タグスパン、カメラからの平均タグ距離、平均タグ面積(画像の割合) |

| botpose_wpiblue | doubleArray | フィールド空間でのロボット変換(青ドライバーステーションWPILIB原点)。移動(X,Y,Z)はメートル、回転(Roll,Pitch,Yaw)は度、合計レイテンシ(cl+tl)、タグ数、タグスパン、カメラからの平均タグ距離、平均タグ面積(画像の割合) |

| botpose_wpired | doubleArray | フィールド空間でのロボット変換(赤ドライバーステーションWPILIB原点)。移動(X,Y,Z)はメートル、回転(Roll,Pitch,Yaw)は度、合計レイテンシ(cl+tl)、タグ数、タグスパン、カメラからの平均タグ距離、平均タグ面積(画像の割合) |

| botpose_orb | doubleArray | フィールド空間でのロボット変換(Megatag2)。移動(X,Y,Z)はメートル、回転(Roll,Pitch,Yaw)は度、合計レイテンシ(cl+tl)、タグ数、タグスパン、カメラからの平均タグ距離、平均タグ面積(画像の割合) |

| botpose_orb_wpiblue | doubleArray | �フィールド空間でのロボット変換(Megatag2)(青ドライバーステーションWPILIB原点)。移動(X,Y,Z)はメートル、回転(Roll,Pitch,Yaw)は度、合計レイテンシ(cl+tl)、タグ数、タグスパン、カメラからの平均タグ距離、平均タグ面積(画像の割合) |

| botpose_orb_wpired | doubleArray | フィールド空間でのロボット変換(Megatag2)(赤ドライバーステーションWPILIB原点)。移動(X,Y,Z)はメートル、回転(Roll,Pitch,Yaw)は度、合計レイテンシ(cl+tl)、タグ数、タグスパン、カメラからの平均タグ距離、平均タグ面積(画像の割合) |

| camerapose_targetspace | doubleArray | 視野内のプライマリAprilTagの座標系でのカメラの3D変換(配列(6))[tx, ty, tz, pitch, yaw, roll](メートル、度) |

| targetpose_cameraspace | doubleArray | カメラの座標系での視野内のプライマリAprilTagの3D変換(配列(6))[tx, ty, tz, pitch, yaw, roll](メートル、度) |

| targetpose_robotspace | doubleArray | ロボットの座標系での視野内のプライマリAprilTagの3D変換(配列(6))[tx, ty, tz, pitch, yaw, roll](メートル、度) |

| botpose_targetspace | doubleArray | 視野内のプライマリAprilTagの座標系でのロボットの3D変換(配列(6))[tx, ty, tz, pitch, yaw, roll](メートル、度) |

| camerapose_robotspace | doubleArray | ロボットの座標系でのカメラの3D変換(配列(6)) |

| tid | int | 視野内のプライマリAprilTagのID |

| stddevs | doubleArray | MegaTag標準偏差 [MT1x, MT1y, MT1z, MT1roll, MT1pitch, MT1Yaw, MT2x, MT2y, MT2z, MT2roll, MT2pitch, MT2yaw] |

| camerapose_robotspace_set | doubleArray | ロボットの座標系で�のカメラの姿勢を設定します。 |

| priorityid | int | tx/tyターゲティングに必要なIDを設定します。他のターゲットを無視します。ローカライゼーションには影響しません |

| robot_orientation_set | doubleArray | ロボットの向きと角速度を度と度/秒で設定します[yaw,yawrate,pitch,pitchrate,roll,rollrate] |

| fiducial_id_filters_set | doubleArray | ローカライゼーション用の有効なフィデューシャルIDをオーバーライドします(配列) |

| fiducial_offset_set | doubleArray | 3D関心点オフセットを設定します [x,y,z] |

カメラコントロール

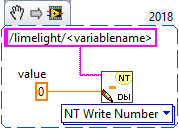

以下のコードを使用します:

- Java

- LabView

- C++

- Python

NetworkTableInstance.getDefault().getTable("limelight").getEntry("<variablename>").setNumber(<value>);

nt::NetworkTableInstance::GetDefault().GetTable("limelight")->PutNumber("<variablename>",<value>);

NetworkTables.getTable("limelight").putNumber('<variablename>',<value>)

このデータを設定します:

| ledMode | LimelightのLED状態を設定します |

|---|---|

| [0] | 現在のパイプラインで設定されたLEDモードを使用 |

| [1] | 強制オフ |

| [2] | 強制点滅 |

| [3] | 強制オン |

| pipeline | Limelightの現在のパイプラインを設定します |

|---|---|

| 0 .. 9 | パイプライン0..9を選択 |

| stream | Limelightのストリーミングモードを設定します |

|---|---|

| 0 | 標準 - WebカメラがLimelightに接続されている場合、サイドバイサイドストリーム |

| 1 | PiPメイン - セカンダリカメラストリームがプライマリカメラストリームの右下隅に配置されます |

| 2 | PiPセカンダリ - プライマリカメラストリーム��がセカンダリカメラストリームの右下隅に配置されます |

| crop | (配列)クロップ矩形を設定します。パイプラインはWebインターフェースでデフォルトのクロップ矩形を使用する必要があります。配列には正確に4つのエントリが必要です。 |

|---|---|

| [0] | X0 - クロップ矩形の最小または最大X値(-1〜1) |

| [1] | X1 - クロップ矩形の最小または最大X値(-1〜1) |

| [2] | Y0 - クロップ矩形の最小または最大Y値(-1〜1) |

| [3] | Y1 - クロップ矩形の最小または最大Y値(-1〜1) |

| throttle_set | (int)無効時は100-200に設定することをお勧めします。温度上昇を抑えるために処理フレーム間でスキップするフレーム数を設定します。スキップされたフレーム中も出力はゼロになりません。 |

|---|

- Java

- C++

double[] cropValues = new double[4];

cropValues[0] = -1.0;

cropValues[1] = 1.0;

cropValues[2] = -1.0;

cropValues[3] = 1.0;

NetworkTableInstance.getDefault().getTable("limelight").getEntry("crop").setDoubleArray(cropValues);

wip

IMUコントロール

| キー | 型 | 説明 |

|---|---|---|

| imumode_set | int | imumodeを設定します。0 - 外部IMUを使用、1 - 外部IMUを使用し内部IMUをシード、2 - 内部を使用、3 - MT1アシスト収束付きで内部を使用、4 - 外部IMUアシスト収束付きで内部IMUを使用 |

| imuassistalpha_set | double | 相補フィルターのアルファ/強度。値が高いほど、内部IMUがアシストソースに素早く収束します。デフォルトは低い値0.001に設定されています。これは内部IMUを以前より信頼するようになったためです。アシストモードは、選択したアシストソースに向けて内部IMUを非常に穏やかに「引っ張る」ように構築されています。 |

Python

Pythonスクリプトは任意の入出力データを許可します。

| llpython | Pythonスクリプトによって送信されるNumberArray。ロボットコード内でアクセス可能です。 |

| llrobot | ロボットによって送信されるNumberArray。Python SnapScripts内でアクセス可能です。 |

生データ

コーナー:

コーナー座標�をストリームするには、"Output"タブで"send contours"を有効にします:

| tcornxy | コーナー座標の数値配列 [x0,y0,x1,y1......] |

生ターゲット:

Limelightは、グループ化モードの影響を受けない3つの生の輪郭をNetworkTablesに投稿します。つまり、パイプラインパラメータでフィルタリングされますが、グループ化されることはありません。XとYは度ではなく正規化されたスクリーン空間(-1〜1)で返されます。

| rawtargets | [txnc,tync,ta,txnc2,tync2,ta2....] |

生フィデューシャル:

すべての有効な(フィルタリングされていない)フィデューシャルを取得します

| rawfiducials | [id, txnc, tync, ta, distToCamera, distToRobot, ambiguity, id2.....] |

生検出:

すべての有効な(フィルタリングされていない)ニューラル検出結果を取得します

| rawdetections | [id, txnc, tync, ta, corner0x, corner0y, corner1x, corner1y, corner2x, corner2y, corner3x, corner3y, id2.....] |

生バーコード:

すべての有効な(フィルタリングされていない)バーコード結果を取得します

| rawbarcodes | バーコードデータの文字列配列 |